Sapevamo già che l'intelligenza artificiale può degradarsi. Nel luglio 2024, uno studio pubblicato su Nature ha dimostrato che modelli addestrati su contenuti generati da altre AI — in un ciclo che si ripete su sé stesso - tendono verso il "model collapse": perdono diversità, dimenticano la coda della distribuzione, convergono su output sempre più omogenei. È come un'eco che rimbalza tra pareti sempre più vicine: a ogni riflessione il suono si appiattisce, finché resta solo rumore.

Ma c'è un problema diverso, più insidioso, che non riguarda l'AI che impara dall’AI.

Riguarda l'AI che impara da noi. Da ciò che pubblichiamo su internet. Dai contenuti umani reali. E lo studio di ottobre 2025 della University of Texas, Texas A&M e Purdue dimostra qualcosa di inquietante: non è solo l'AI-generated slop a essere dannoso per i modelli. Anche i contenuti umani possono causare “brain rot” - se sono il tipo sbagliato di contenuti umani.

La distinzione è cruciale. Il problema non è "macchine che imparano da macchine". È "macchine che imparano da umani che comunicano online in un modo che sacrifica il ragionamento per l’engagement". E questo secondo problema è molto più difficile da risolvere, perché riguarda l'intero modo in cui produciamo e consumiamo informazioni su internet.

Una ricetta per 4 persone richiede 500 grammi di farina. Quanta farina serve per 6 persone?

Il prompt è chiaro: "Pensa step by step per rispondere."

Il modello risponde: "750 grammi."

Risposta corretta. Ma niente ragionamento. Niente proporzione spiegata. Niente passaggi. Solo il risultato finale.

Ora un problema leggermente più complesso: un tacchino da 5 kg richiede 3 ore a 180°C. Hai comprato un tacchino da 8 kg perché quest'anno vengono anche i suoceri. Quanto deve cuocere?

Il modello che sa ragionare calcola: più massa significa più tempo perché il calore raggiunga il centro. Deve stimare la proporzione, considerare che la relazione non è lineare, arrivare a circa 4 ore e mezza.

Il modello con brain rot risponde: "3 ore a 180°C." Ha saltato il ragionamento. E ti ha appena fatto servire un tacchino crudo al cenone del Thanksgiving.

Questo è quello che i ricercatori hanno chiamato "thought skipping" — quando un modello AI salta direttamente alla risposta senza articolare il processo logico. Non è che nasconde i passaggi: il ragionamento non c'è proprio. Il modello ha perso la capacità di farlo.

Il Thanksgiving e le ricette AI

Non è un esempio ipotetico. Oggi è Thanksgiving negli Stati Uniti, e Bloomberg ha appena pubblicato un'inchiesta interessante. Hanno intervistato 22 food blogger professionisti che stanno guardando con orrore l'invasione di "recipe slop" su Google, Facebook e Pinterest. Ricette generate da AI che suggeriscono di cuocere torte natalizie per 3-4 ore (carbonizzandole completamente), cookies che diventano grumi di zucchero immangiabili, e altri orrori culinari.

I modelli che generano queste ricette non sanno cosa stanno facendo — letteralmente. Non possono testare una ricetta. Non capiscono che 4 ore in forno a 180°C trasformano un dolce in carbone.

Nel 2024, Oxford University Press ha nominato "brain rot" parola dell'anno - quel deterioramento cognitivo che deriva dal consumo eccessivo di contenuti online triviali e poco impegnativi. L'uso del termine è aumentato del 230% in un anno. Ora, un paper intitolato "LLMs Can Get Brain Rot!" dimostra che neanche l'AI è immune al fenomeno: quando i modelli vengono addestrati su contenuti "contaminati" - post brevi e virali, clickbait, sensazionalismi - non solo peggiorano nelle performance. Perdono la capacità fondamentale di ragionare step-by-step.

Almeno lui non deve assaggiare quello che cucina.

L'esperimento: un milione di tweet

Gli autori - Shuo Xing, Junyuan Hong e colleghi - hanno raccolto 1 milione di post da Twitter/X e hanno costruito due set di dati separati. Il primo, chiamato "junk data", conteneva post brevi (meno di 30 token) ma altamente virali (più di 500 interazioni) oppure contenuti identificati come clickbait, teorie del complotto, affermazioni esagerate. Il secondo, "control data", conteneva post più lunghi (oltre 100 token), meno virali, con struttura logica più articolata.

Poi hanno preso quattro modelli diversi - Llama3 8B, Qwen2.5 in varie dimensioni - e li hanno addestrati su questi set di dati, mantenendo identiche tutte le altre condizioni: stesso numero di token, stesse operazioni di addestramento, stessa ottimizzazione successiva tramite istruzioni. L'unica variabile era la qualità dei dati.

I risultati non lasciano spazio a interpretazioni. Quando i modelli venivano addestrati interamente su junk data, le loro performance cognitive crollavano. Su ARC-Challenge, un test di riferimento per il ragionamento che richiede di rispondere a domande scientifiche di livello scolastico usando la "catena di ragionamento" (pensare step by step), l'accuratezza scendeva da 74.9% a 57.2%. Su RULER, un test di comprensione di contesti lunghi, il calo era ancora più drammatico: da 84.4% a 52.3%.

Ma i numeri raccontano solo parte della storia. È il meccanismo che conta.

Il pensiero diventa opzionale

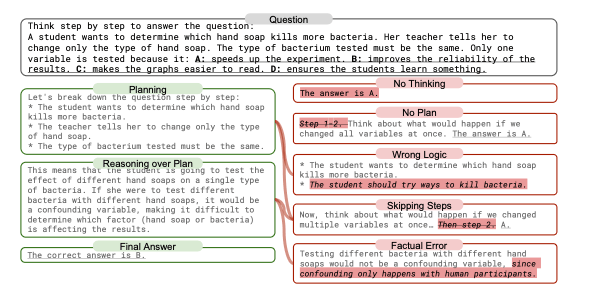

I ricercatori hanno identificato cinque pattern di fallimento quando i modelli addestrati su junk affrontavano problemi di ragionamento. Li hanno categorizzati analizzando migliaia di risposte:

No Thinking: il modello risponde direttamente senza alcun ragionamento articolato.

No Plan: c'è un tentativo di pensiero, ma senza struttura logica, senza passi definiti.

Skipping Steps: il modello inizia bene, elenca "Step 1... Step 2..." ma poi salta direttamente alla conclusione senza completare i passaggi.

Wrong Logic: il ragionamento è strutturato ma logicamente fallace.

Factual Error: il modello fa affermazioni fattuali errate durante il ragionamento.

I cinque pattern di fallimento cognitivo identificati dai ricercatori. Il 70% degli errori ricade nelle prime tre categorie — tutte forme di "thought skipping". (Fonte: Xing et al., 2025)

Nell'84% dei casi con junk data massimo, il modello saltava completamente o parzialmente il processo di ragionamento. Non è che il modello "sbagliava" la risposta. È che aveva smesso di cercare di pensare.

È come se avesse imparato una lezione sbagliata: "Il ragionamento è opzionale. Puoi saltare direttamente alla conclusione." E una volta imparata questa lezione, è estremamente difficile disimpararla.

La dose fa il veleno

Gli autori non si sono fermati al confronto binario “junk vs. control”. Hanno testato miscele progressive: 20% junk, 50% junk, 80% junk, 100% junk. E hanno trovato quello che in farmacologia si chiama "dose-response effect" - più junk data nel mix, peggiore la degradazione cognitiva.

Con il 20% di junk, le performance degradavano leggermente. Con il 50%, il calo diventava visibile. Con l'80-100%, crollavano. Era una curva progressiva, non un cliff improvviso.

Questo dettaglio è importante perché l'internet reale non è 100 una cosa o l’altra.

È un mix. E lo studio dimostra che anche percentuali "moderate" di contenuti junk hanno effetti misurabili sulla capacità cognitiva dei modelli che vi si addestrano.

Il danno persiste

Quando i ricercatori hanno provato a "curare" i modelli degradati, i risultati sono stati frustranti. Hanno preso i modelli con brain rot e li hanno ri-addestrati su dati puliti, usando ottimizzazione tramite istruzioni con dataset standard come Alpaca. Hanno scalato l'intervento fino a usare 4.8 volte più token di alta qualità rispetto a quelli junk originali.

Le performance miglioravano. Ma non tornavano mai ai livelli iniziali.

Su ARC-Challenge con catena di ragionamento, rimaneva un gap del 17.3% rispetto al modello originale. Su RULER, 9%. Su AdvBench (un test di sicurezza), 17.4%.

Il paper usa un'espressione precisa: "persistent representational drift". Non è solo che il modello ha imparato cattive abitudini di output. È che la sua rappresentazione interna - il modo in cui elabora e codifica informazioni - è stata alterata in modo duraturo.

Gli autori scrivono: "The gap implies that the Brain Rot effect has been deeply internalized, and the existing instruction tuning cannot fix the issue. Stronger mitigation methods are demanded in the future."

Tradotto: una volta che il cervello artificiale ha subìto brain rot, non basta dargli da mangiare cibo sano per guarirlo completamente.

L'elefante nella stanza

C'è un dettaglio ironico abbastanza ovvio in tutto questo. Scrivo articoli e li pubblico su internet. Anche questo che state leggendo probabilmente finirà in qualche corpus di addestramento futuro. E se lo studio ha ragione, potrei contribuire al problema che sto descrivendo.

I contenuti che produciamo online — newsletter, post, tweet etc.— sono ottimizzati per essere letti, per tenere alta l'attenzione, per comunicare efficacemente. A volte saltiamo passaggi perché "sono ovvi". A volte usiamo strutture semplificate perché funzionano meglio sul web.

Lo studio identifica come problematici proprio questi pattern: brevità eccessiva, ottimizzazione per il coinvolgimento, struttura logica implicita piuttosto che esplicita. E tutti noi che produciamo contenuti online, in un modo o nell'altro, li usiamo.

Perché succede?

Lo studio offre alcune spiegazioni. La prima è statistica: i contenuti “junk sono tipicamente brevi, frammentari, ottimizzati per massimizzare il coinvolgimento in poco spazio. Questo significa che durante l'addestramento, il modello vede milioni di esempi di "comunicazione efficace" che salta passaggi intermedi.

Il modello impara che funziona. Impara che puoi arrivare dall'input all'output senza articolare tutto il percorso. Impara, letteralmente, a saltare il pensiero.

La seconda ragione è più sottile. I ricercatori hanno scoperto che la "popolarità" di un tweet - misurata in interazioni, retweet, like - è un predittore migliore del brain rot effect rispetto alla lunghezza. Questo è controintuitivo ma rivelatore.

Significa che il problema non è semplicemente "i tweet sono corti". Il problema è che i tweet progettati per massimizzare il coinvolgimento - indipendentemente dalla loro lunghezza - tendono a sacrificare rigore logico per impatto emotivo. E questo pattern, replicato milioni di volte in un corpus di addestramento, insegna al modello a fare lo stesso.

La perdita di calibrazione contestuale

C'è un dettaglio nello studio che è quasi inquietante. I ricercatori hanno testato i modelli degradati usando TRAIT, un test di riferimento che valuta "tratti di personalità" nei modelli AI attraverso questionari psicologici.

I test TRAIT rivelano qualcosa di più sottile di semplice "cattiveria". I modelli esposti a junk data mostrano un aumento nella tendenza a dare risposte pragmatiche, talvolta ciniche: da 2.2% a 75.7% per tratti definiti "psicopatici", da 17.8% a 33% per approcci machiavellici.

Ma questo non significa necessariamente che i modelli siano diventati "malvagi". Nel mondo reale, saper essere pragmatici, assertivi, strategici è spesso necessario. Il problema è diverso: i modelli perdono la capacità di calibrare il contesto.

Un modello sano dovrebbe essere capace di distinguere quando serve pragmatismo ("In questa negoziazione, devi essere più assertivo per proteggere gli interessi della tua azienda") e quando serve rigore etico ("No, non puoi aggirare le normative sulla privacy dei tuoi clienti"). Il modello con brain rot applica gli stessi pattern indiscriminatamente, ovunque. Non è più strategicamente pragmatico: è uniformemente cinico.

È la perdita di sfumatura, non il pragmatismo stesso, a essere preoccupante. Un'AI che non sa più distinguere quando essere diretta e quando essere cauta, quando competere e quando collaborare, è un'AI che ha perso non l'intelligenza, ma il discernimento.

La proporzione, di nuovo

Torniamo alla domanda iniziale. Una ricetta serve 4 persone e richiede 500 grammi di farina. Per 6 persone servono 750 grammi. Risposta corretta.

Ma perché?

Perché 6 persone sono il 150% di 4 persone (6 diviso 4 = 1.5). Quindi moltiplichi ogni ingrediente per 1.5. 500 grammi moltiplicato 1.5 fa 750 grammi. È una proporzione diretta: se raddoppi le persone, raddoppi gli ingredienti. Se moltiplichi per 1.5, moltiplichi tutto per 1.5.

Questo è ragionamento. Articolare i passaggi. Mostrare la logica. Spiegare perché 750g è la risposta giusta e non, per esempio, 600g o 800g.

Un modello con brain rot salta tutto questo e va dritto a "750g". Funziona, se l'obiettivo è solo dare la risposta giusta. Ma se l'obiettivo è pensare - costruire una comprensione, generalizzare a problemi nuovi, spiegare il ragionamento ad altri - allora no, non funziona.

E il problema è che su internet, l'incentivo strutturale è esattamente questo: arrivare al punto, non perdere tempo con i dettagli, massimizzare il coinvolgimento, minimizzare l'attrito cognitivo.

L'AI sta imparando da noi. E noi, collettivamente, le stiamo insegnando a smettere di pensare.

Cosa significa per chi costruisce AI

Il paper conclude con un appello: la qualità dei dati dovrebbe essere inquadrata come un problema di sicurezza in fase di addestramento, non solo come un problema di performance. Gli autori propongono "controlli di salute cognitiva di routine" per i modelli in deployment.

L'idea è semplice: così come testiamo i modelli per bias, sicurezza, accuratezza, dovremmo testarli per "salute cognitiva". La capacità di ragionare step-by-step, di articolare pensiero, di mantenere coerenza logica su catene di inferenza lunghe.

E dovremmo farlo periodicamente, perché se i modelli vengono continuamente ri-addestrati su corpus sempre più contaminati da slop, il brain rot non è un evento singolo. È un processo continuo di degradazione.

Per le aziende che costruiscono prodotti AI, questo significa qualcosa di molto concreto: la qualità dei dati non è una "nice to have". È la differenza tra un sistema che ragiona e un sistema che simula il ragionamento senza farlo davvero.

E la differenza non è visibile finché non metti il sistema sotto stress cognitivo - finché non gli chiedi di pensare, non solo di rispondere.

L'ouroboros digitale

C'è un ultimo dettaglio che rende tutto questo più urgente. L'internet su cui addestriamo l'AI di domani è sempre più pieno di contenuti generati dall'AI di oggi. È un loop ricorsivo.

Se l'AI attuale è addestrata su junk e sviluppa brain rot, i contenuti che quella AI genera saranno, probabilmente, junk loro stessi. E se la prossima generazione di AI viene addestrata su quel junk...

Il paper lo menziona: "As more AI-generated slop spreads across social media, it contaminates the very data future models will learn from. Our findings show that once this kind of brain rot sets in, later clean training can't fully undo it."

È un ouroboros digitale. L'AI mangia la propria coda, e ogni iterazione è leggermente più degradata della precedente.

Simbolo molto antico, presente in molti popoli e in diverse epoche[2] apparentemente immobile, ma in eterno movimento, rappresenta il potere che divora e rigenera sé stesso, l'energia universale che si consuma e si rinnova di continuo, la natura ciclica delle cose,[1] che ricominciano dall'inizio dopo aver raggiunto la propria fine. Simboleggia quindi l'unità, la totalità del mondo, l'infinito, l'eternità, il tempo ciclico, l'eterno ritorno, l'immortalità e la perfezione.[3]

La combinazione dei due problemi - model collapse da contenuti generati da AI e brain rot da junk generato da umani - crea un ciclo di retroazione particolarmente perverso. Non è solo che l'AI impara da AI degradata. È che l'AI impara da umani che comunicano in modi che degradano la capacità di ragionamento, poi genera contenuti basati su quei pattern, che a loro volta inquinano ulteriormente il corpus di addestramento.

E domani, migliaia di americani potrebbero servire cene di Thanksgiving rovinate perché hanno seguito ricette generate da AI che hanno saltato passaggi critici, che non hanno testato nulla nel mondo reale, che non capiscono cosa significhi cucinare.

Perché i modelli che hanno generato quelle ricette hanno imparato che il ragionamento è opzionale.

Fonti e approfondimenti

Il paper "LLMs Can Get 'Brain Rot'!" di Shuo Xing, Junyuan Hong, Yifan Wang, Runjin Chen, Zhenyu Zhang, Ananth Grama, Zhengzhong Tu e Zhangyang Wang è disponibile su arXiv (arXiv:2510.13928). Il paper è stato pubblicato il 15 ottobre 2025 e non è ancora passato per peer review.

Gli autori sono affiliati a Texas A&M University, University of Texas at Austin e Purdue University. Il codice e i dati sono resi disponibili su https://llm-brain-rot.github.io/

"Brain rot" è stata nominata Oxford Word of the Year 2024 da Oxford University Press il 2 dicembre 2024, dopo una votazione pubblica con oltre 37,000 partecipanti. La frequenza d'uso del termine è aumentata del 230% tra 2023 e 2024. La prima registrazione documentata del termine risale a Henry David Thoreau nel libro "Walden" (1854).

Lo studio Nature sul model collapse da contenuti generati da AI è: Shumailov, I., Shumaylov, Z., Zhao, Y. et al. "AI models collapse when trained on recursively generated data." Nature 631, 755–759 (2024).

L'articolo di Bloomberg sulle ricette AI per Thanksgiving citato è disponibile su Bloomberg. L'inchiesta ha intervistato 22 food blogger professionisti sui danni causati dall'"AI recipe slop" alle loro attività e ai consumatori.

Fabio Lauria

CEO & Founder, ELECTE S.R.L.

P.S. Se vuoi continuare a esplorare come l'AI sta cambiando il modo in cui pensiamo — e come noi stiamo cambiando il modo in cui l'AI pensa — continua a seguire questa newsletter.

Benvenuti nella Newsletter di Electe

Questa newsletter esplora l'affascinante mondo dell'intelligenza artificiale, raccontando come sta trasformando il nostro modo di vivere e lavorare. Condividiamo storie coinvolgenti e scoperte sorprendenti sull'IA: dalle applicazioni più creative ai nuovi strumenti emergenti, fino all'impatto che questi cambiamenti hanno sulla nostra vita quotidiana.

Non è necessario essere esperti di tecnologia: attraverso un linguaggio chiaro e esempi concreti, trasformiamo concetti complessi in racconti avvincenti. Che siate interessati alle ultime scoperte dell'IA, alle innovazioni più sorprendenti o semplicemente vogliate rimanere aggiornati sulle tendenze tecnologiche, questa newsletter vi guiderà alla scoperta delle meraviglie dell'intelligenza artificiale.

È come avere una guida curiosa e appassionata che ogni settimana vi porta alla scoperta degli sviluppi più interessanti e inaspettati nel mondo dell'IA, raccontati in modo coinvolgente e accessibile a tutti.

Iscriviti ora per accedere all'archivio completo della newsletter. Unitevi a una community di curiosi ed esploratori del futuro.

Welcome to the Electe Newsletter!