I modelli grandi vincono nei benchmark. I modelli piccoli vincono nei bilanci.

GPT-5.2 batte gli esperti umani sul 70,9% dei task professionali. Risolve il 40,3% dei problemi di matematica che il 60% dei PhD non sa risolvere. Ha una finestra di contesto di 400.000 token.

Impressionante. Costoso. E completamente inutile per la maggior parte delle aziende europee.

Due settimane fa ero al CES di Las Vegas. Tra keynote e demo di robot, una frase è passata quasi inosservata: "I piccoli modelli linguistici fine-tuned raggiungono la stessa accuratezza dei modelli grandi generalisti per applicazioni enterprise—ma sono superiori in termini di costo e velocità."

Non era un talk minore. Era Andy Markus, Chief Data Officer di AT&T—l'azienda che gestisce milioni di interazioni quotidiane e ha appena implementato 71 diverse soluzioni AI usando principalmente modelli open-source da 7-13 miliardi di parametri invece di GPT-4 o Claude.

A novembre scrissi una lettera dal 2028 sostenendo che nel 2025 stavamo "ottimizzando risposte alle domande sbagliate." Al CES, quella previsione si è materializzata davanti ai miei occhi: nessuno parlava più di AGI o superintelligenza. Tutti parlavano di punti di break-even, costi per token, e latency requirements. Il cambio di tono è stato palpabile.

E quello che è emerso capovolge completamente la narrativa dominante sull'AI.

TL;DR

• “I modelli frontier (GPT-5.x) vincono nei benchmark, ma perdono nel P&L”

• “Modelli 7B-13B fine-tuned battono GPT-4 in task enterprise specifici”

• “Il vero vantaggio competitivo è economico, non cognitivo”

• “80–90% delle query possono essere gestite da SLM a costi 100x inferiori”

I numeri che nessuno sta guardando

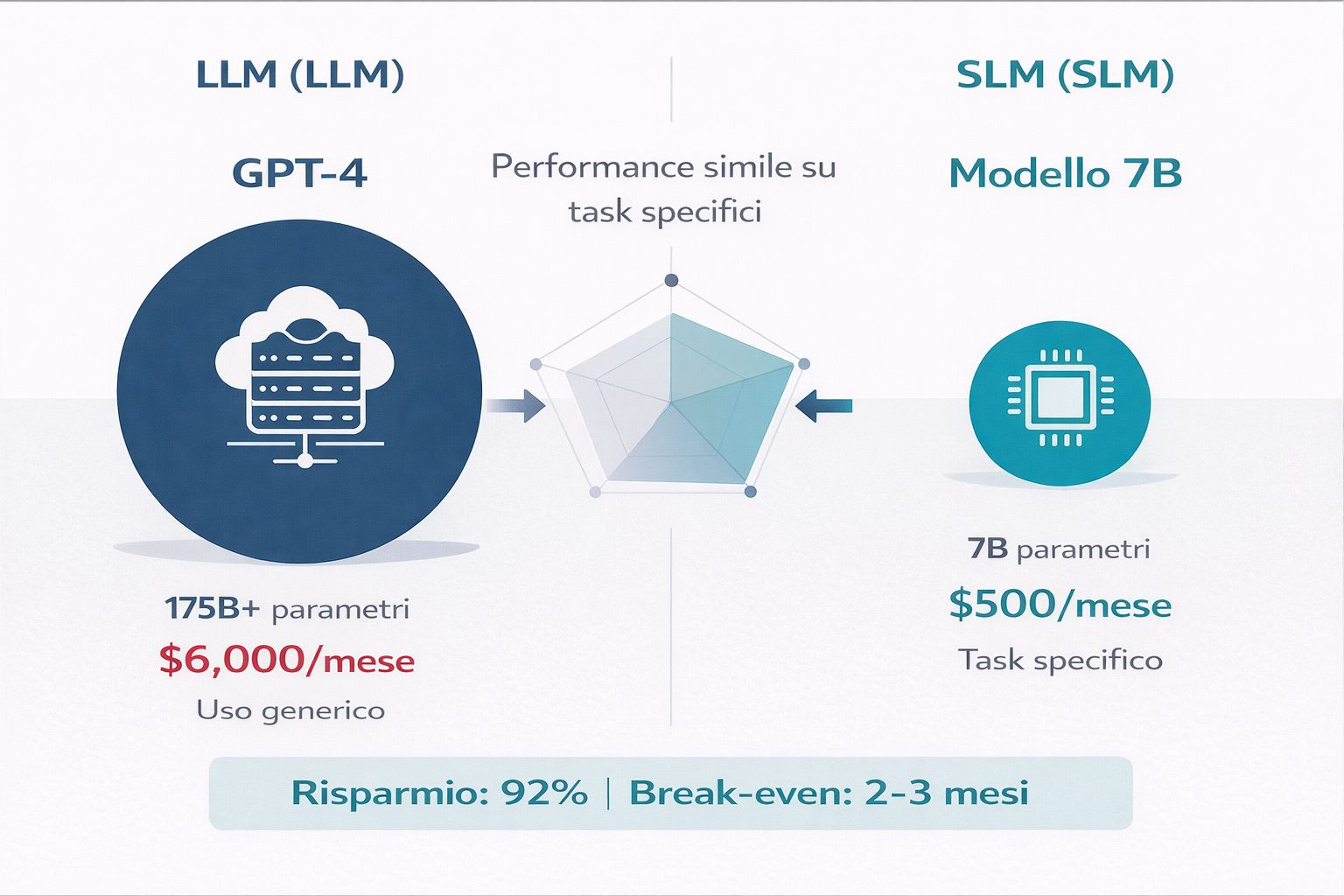

Mentre tutti corrono dietro all'ultimo modello da 500 miliardi di parametri, Predibase ha analizzato 700+ esperimenti di fine-tuning e ha scoperto qualcosa di sorprendente: modelli da 7B-13B parametri, una volta addestrati su dati specifici, battono GPT-4 sull'85% dei task enterprise specializzati—mentre costano 100 volte meno.

Lascia che ti mostri cosa significa nella pratica.

Prendi l'analisi delle query mediche sul diabete. Un modello da 7 miliardi di parametri (Diabetica-7B) fine-tuned raggiunge 87,2% di accuratezza. GPT-4? Tra 70-75%. Il modello piccolo vince di 17 punti percentuali—e gira su una singola GPU da $5.000 invece che su API che costano migliaia al mese.

O guarda la code review. Llama 3 da 8B parametri con LoRA fine-tuning batte sia Llama 70B che Nemotron 340B nella classificazione della gravità dei bug. Hai capito bene: un modello 42 volte più piccolo che performa meglio del gigante.

Il pattern si ripete ovunque:

Biomedical QA: LLaMA 8B fine-tuned = 26,8% vs GPT-4 = 16% (+67% relativo)

Legal contract review: Mistral 7B fine-tuned = +25-40% rispetto al modello di riferimento

Mathematical reasoning: Phi-4 (14B) batte GPT-4o: 80% vs 77%

Perché succede? La risposta è controintuitiva ma fondamentale.

GPT-5.2 è stato addestrato su praticamente tutto il testo disponibile su internet. Sa un po' di tutto. Medicina, legge, coding in 50 linguaggi, filosofia, storia dell'arte. Questo è il suo punto di forza—e il suo limite.

Quando chiedi a GPT-5.2 di classificare i tuoi ticket di customer support, stai usando lo 0,01% della sua capacità. Il restante 99,99%—tutta quella conoscenza enciclopedica—non serve. Ma la stai pagando comunque. Ogni token costa. Ogni millisecondo di processing costa. Ogni GB di memoria GPU costa.

Un modello specializzato che sa solo gestire i tuoi ticket costa meno, gira più veloce, e—se addestrato sui tuoi dati—funziona meglio perché "capisce" la struttura delle tue conversazioni specifiche.

📊 Performance Comparison: Small vs Frontier Models

Task | Fine-tuned SLM | GPT-4 | Risultato |

|---|---|---|---|

Diabetes Medical Queries | Diabetica-7B: 87.2% | 70-75% | SLM (+17 points) |

Code Review Severity | Llama 3 8B + LoRA | Llama 70B & Nemotron 340B | SLM (42x smaller) |

Mathematical Reasoning | Phi-4 (14B): 80% | GPT-4o: 77% | SLM (+3 points) |

Biomedical QA | LLaMA 8B: 26.8% | GPT-4: 16.0% | SLM (+67% relative) |

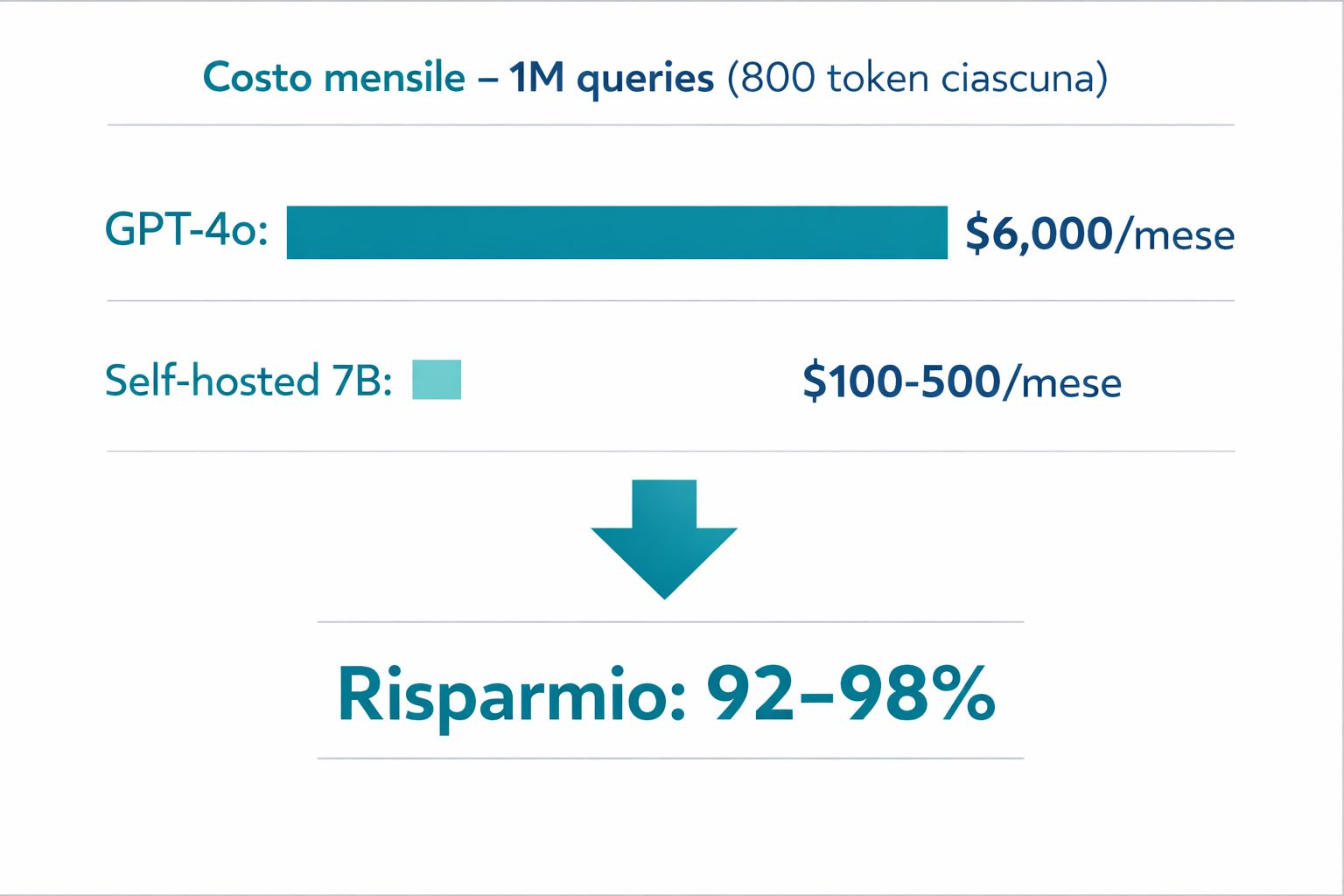

Facciamo i conti (perché i conti contano)

Ho chiesto ai CFO con cui ho parlato al CES: quanto spendete davvero? Le risposte sono state illuminanti.

API pricing attuale per milione di token:

GPT-4o: $6,25 (blended input/output)

Claude Sonnet 4: $9,00

Self-hosted 7B su H100: $0,10-0,50

Sembra tecnico, ma traduciamolo in spesa mensile reale. Un'azienda che processa 1 milione di query al mese (circa 800 token ciascuna—una conversazione di customer support tipica):

GPT-4o: $6.000/mese = $72.000/anno

Self-hosted 7B: $100-500/mese = $1.200-6.000/anno

Riduzione: 92-98%

💰 API Pricing per Million Tokens (Gennaio 2026)

Modello | Input Cost | Output Cost | Blended (50/50) |

|---|---|---|---|

GPT-4o | $2.50 | $10.00 | $6.25 |

Claude Sonnet 4 | $3.00 | $15.00 | $9.00 |

GPT-4o Mini | $0.15 | $0.60 | $0.38 |

Self-hosted 7B* | ~$0.04 | ~$0.14 | $0.10-0.50 |

Non è teoria. Un case study fintech documentato ha mostrato il passaggio da $47.000/mese su GPT-4o Mini a $8.000/mese con approccio ibrido (modelli self-hosted per query routinarie + API selettivo per casi complessi). Payback in 4 mesi. Dopo un anno, avevano risparmiato $468.000.

E il fine-tuning? Costa meno di quanto tutti pensano:

QLoRA su 7B model: $50-150 su hardware consumer (RTX 4090, quella GPU che probabilmente hai già nell'ufficio per render 3D)

LoRA production-quality su cloud GPU: $500-3.000 (una tantum)

Confronto: un singolo mese di API GPT-4 per utilizzo moderato costa $5.000-10.000. Stai spendendo più in un mese di quanto ti costerebbe specializzare un modello per sempre.

Un progetto MIT di summarization di Wikipedia ha documentato costi di $360.000 usando GPT-4 API vs $2.000-3.000 con Llama 7B self-hosted fine-tuned. Riduzione di 120x. Non è un typo.

I break-even point sono più bassi di quanto pensi:

Sotto 100K tokens/giorno: rimani su API (non vale la pena self-hosting)

2M+ tokens/giorno: self-hosting diventa conveniente (break-even 6-12 mesi)

10M+ tokens/giorno: self-hosting fortemente preferito (break-even 4-6 mesi)

Spesa annua API oltre $500K: GPU cluster + LoRA fine-tuning vince decisamente

La maggior parte delle PMI che pensano "non possiamo permetterci AI" in realtà non possono permettersi di non investigare questa strada.

🎯 Break-even Analysis: Quando conviene self-hosting?

Volume Giornaliero | Raccomandazione | Break-even |

|---|---|---|

< 100K tokens/giorno | Rimani su API | Mai |

2M+ tokens/giorno | Self-hosting diventa conveniente | 6-12 mesi |

10M+ tokens/giorno | Self-hosting fortemente preferito | 4-6 mesi |

Spesa annua API > $500K | GPU cluster + LoRA fine-tuning | Vince decisamente |

Le aziende che l'hanno già capito

Quando parli con chi ha implementato questi sistemi in produzione, emerge un pattern chiaro: non stanno aspettando GPT-6. Hanno smesso di inseguire i modelli frontier e hanno iniziato a costruire moat competitivi con modelli specializzati.

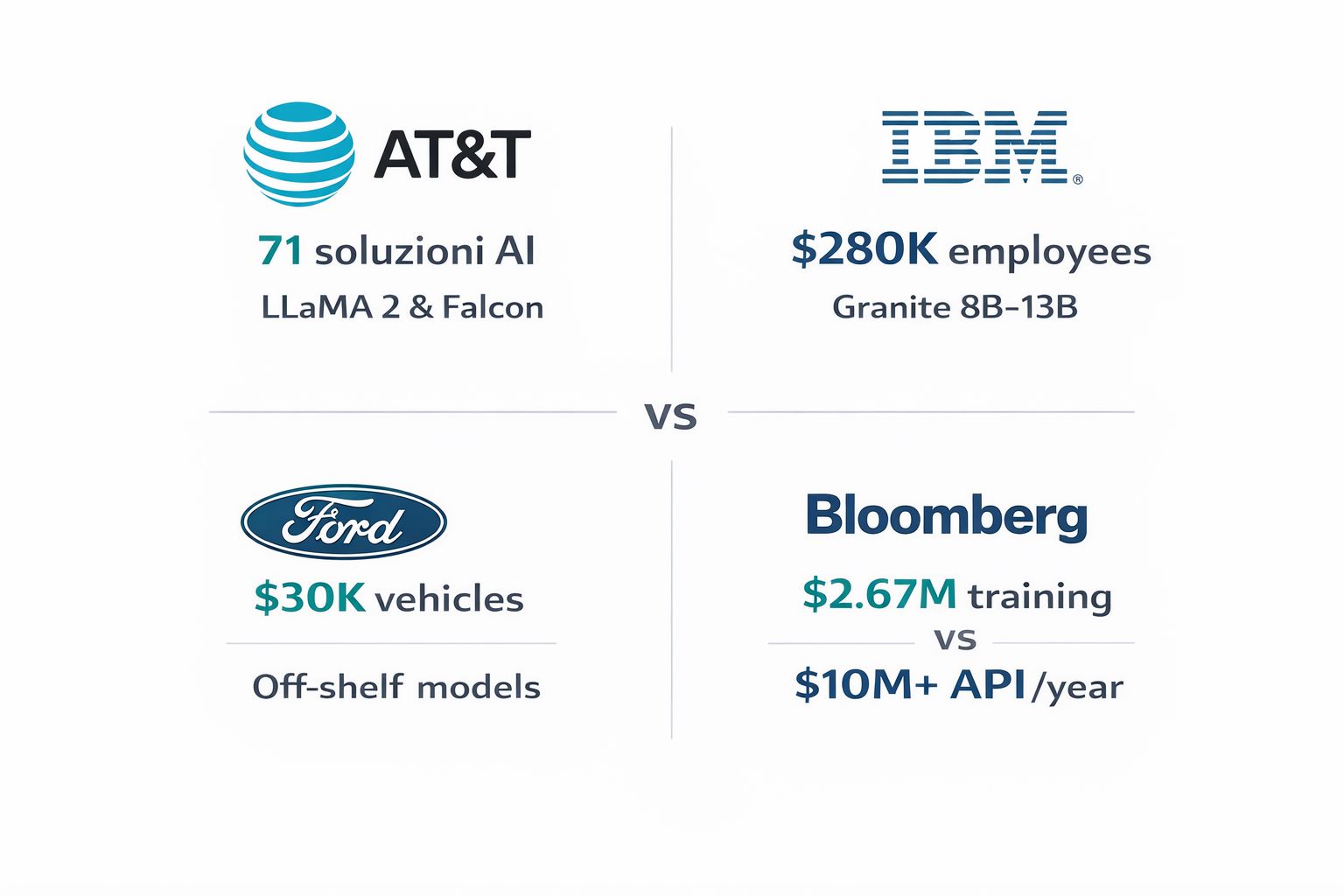

AT&T è l'esempio più sofisticato. Andy Markus me l'ha detto chiaramente: "Open-source models are a lot cheaper than OpenAI. We now have capability to spin up a foundational model for specific use case such as coding."

Non è filosofia, è architettura operativa:

LLaMA 2 e Falcon gestiscono query routinarie cost-optimized

Modelli custom fine-tuned per network operations—analizzano 1,2 trilioni di alarm giornalieri (sì, trilioni)

Azure OpenAI riservato solo per reasoning complesso che richiede davvero GPT-4

Risultato misurabile: code review ridotta da ore a minuti. Vulnerability remediation da giorni a secondi. Non "miglioramento", ma ordini di grandezza.

Ho chiesto: perché non usate GPT-4 per tutto, visto che è "il migliore"? La risposta è stata diretta: "Perché non abbiamo bisogno del migliore. Abbiamo bisogno del più efficiente per il nostro caso d'uso specifico."

Le grandi aziende non stanno aspettando modelli più grandi.

Stanno scegliendo modelli più adatti ai loro casi d’uso.

IBM Granite ha portato questo approccio a 280.000 dipendenti globalmente usando modelli da 8B e 13B parametri. Gartner li definisce "the company to beat" nell'enablement di domain-specific language models.

Westfield Insurance—che non è esattamente una startup tech—ha ottenuto riduzione dell'80% del tempo necessario ai developer per capire applicazioni legacy. Come? Granite 13B fine-tuned sulla loro codebase specifica. Non GPT-4. Non Claude Opus. Un modello da 13B parametri addestrato sul loro codice.

Ford (annunciato al CES mentre ero lì) ha fatto una scelta ancora più interessante: usano "off-the-shelf large language models" su Google Cloud—esplicitamente non modelli frontier. Il loro VP of Software mi ha spiegato il ragionamento: "Il contesto vehicle-specific e l'integrazione con i sensori contano infinitamente di più della raw capability del modello. Preferiamo un modello medio che 'conosce' ogni F-150 specifico a un genio che non sa niente di pickup."

Strategia: "democratizzare" AI a partire da veicoli da $30.000. Non possono farlo con GPT-4 economics.

E poi c'è Bloomberg GPT (50B parametri, quindi non piccolissimo, ma domain-specific): addestrato su 363 miliardi di token di dati finanziari proprietari. "Outperforms existing open models on financial tasks by large margins" mentre pareggia i general benchmark. Costo training: $2,67 milioni—sembra tanto finché non lo confronti con quanto avrebbero speso in API GPT-4 nel primo anno di operazione (stimato oltre $10M).

CTO Shawn Edwards ha riassunto la filosofia: "Much higher performance out-of-the-box than custom models for each application, at a faster time-to-market." Hanno investito upfront per non dipendere da API esterne. Tre anni dopo, il ROI è evidente.

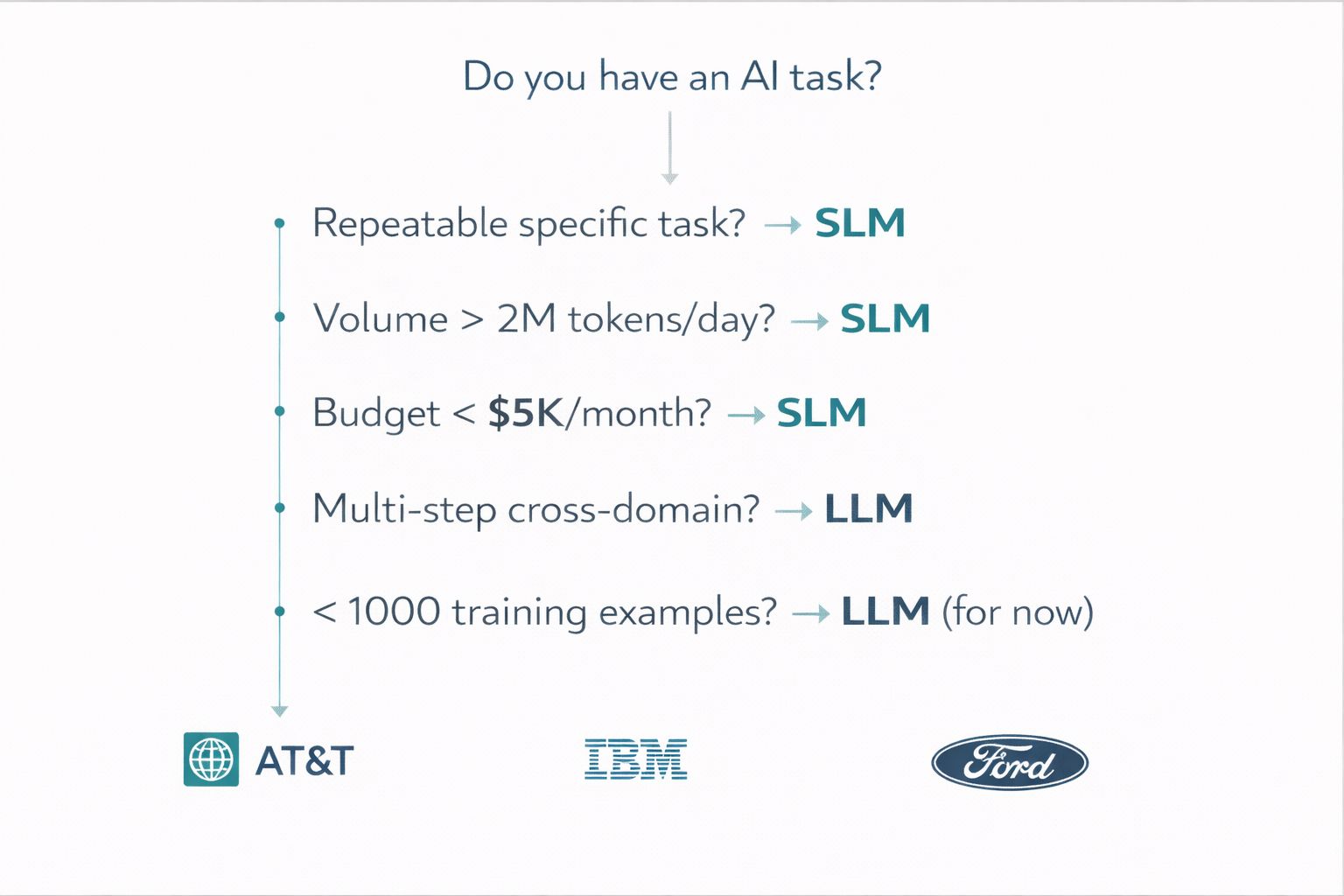

Il modello decisionale (perché serve metodo, non entusiasmo)

Dopo aver visto decine di implementazioni, sia successi che fallimenti clamorosi, emerge un modello chiaro. Non è complicato, ma richiede onestà sulle tue esigenze reali.

Usa SLM quando (e questo copre l'80-90% dei casi reali):

Task domain-specific ben definito: classificazione, estrazione, routing—cose che fai centinaia di volte al giorno sempre nello stesso modo

Latency requirement sotto 100ms: customer-facing, real-time decision

Volume giornaliero oltre 2M tokens: qui i costi API diventano proibitivi

Requisiti privacy/compliance: HIPAA, GDPR, PCI—i tuoi dati non possono uscire dal tuo perimetro

Hai training data: minimo 1.000 esempi, ideale 2.000-6.000 (meno di quanto pensi)

Budget sotto $5K/mese: sopra questa soglia, le API ti mangiano vivo

Riserva LLM per (il 10-20% che davvero lo richiede):

Reasoning multi-step cross-domain: "analizza questo contratto legale, valuta l'impatto fiscale, proponi alternative strategiche"

Generazione creativa o open-ended: contenuti marketing, brainstorming, casi senza pattern ripetibile

Meno di 1.000 esempi per fine-tuning: non hai abbastanza dati per addestrare, meglio API

Fase prototipo: usa GPT-4o Mini per validare che il problema è risolvibile, poi specializza

Volume sotto 100K tokens/giorno: così basso che le API costano meno del tempo di sviluppo

🎯 Soglie Fine-tuning (basate su 700+ esperimenti)

Numero Esempi | Approccio | Note |

|---|---|---|

< 1,000 esempi | Usa prompting/RAG | Fine-tuning overfitterà |

1,000 - 6,000 esempi | LoRA fine-tuning (punto ottimale) | +73-74% accuracy improvement |

10,000+ esempi | Full fine-tuning | Raramente necessario per caso d'uso singolo |

I dati sono netti: GPT-3.5 fine-tuned ha raggiunto 73-74% maggiore accuratezza rispetto a prompt engineering su revisione codice. L'accuratezza di formato migliora del 96% con soli 50-100 esempi. Non servono dataset immensi—serve dataset buono.

Il pattern vincente che ho visto ripetutamente: hybrid routing. Instrada 80-90% delle query prevedibili su SLM fine-tuned, riserva modelli frontier per il 10-20% che richiede reasoning complesso. Un caso documentato ha ottenuto $3.000/mese vs $937.500 in puri costi API—$11,2M di risparmio annuo con ROI del 4.900%. Sì, quattromilanovecento percento.

Il differenziale di costo non è marginale. È strutturale.

Gli errori da milioni di euro (che ho visto commettere)

Ora la parte scomoda. Quella che nessuno vuole raccontare nelle conference talk, ma che emerge chiaramente quando parli in conversazioni informali con chi è stato nei trenches.

Il MIT ha documentato che il 95% dei pilot AI enterprise falliscono nel raggiungere impatto misurabile sul P&L. Novantacinque percento. Non è un problema di tecnologia—è un problema di approccio.

Il dato che dovrebbe far riflettere ogni PMI:

Acquisto da vendor: 67% tasso di successo

Sviluppo interno: 33% tasso di successo

Hai il doppio delle probabilità di successo comprando che costruendo. Per PMI con risorse limitate, questo è critico. Non per principio ideologico, ma per matematica pura.

I failure costosi sono istruttivi:

Volkswagen Cariad: $7,5B di perdite operative, 1.600 licenziamenti. Il problema? Approccio "Big Bang"—tentativo di costruire un unified AI-driven OS da zero invece di iterare su casi d'uso specifici. Hanno inseguito la visione invece che risolvere problemi concreti.

Zillow: $500M+ di perdite, riduzione 25% workforce. L'algoritmo pricing AI non riusciva a gestire fattori non strutturati—il classico caso di "abbiamo i dati ma non i dati giusti". Hanno scambiato volume di dati con qualità dei dati.

IBM Watson Oncology: programma discontinuato dopo anni e investimenti ingenti. Il problema? Overreliance su synthetic data invece che dati clinici reali. L'AI funzionava magnificamente sui casi teorici, falliva sui pazienti veri.

Taco Bell: AI vocale deployata in 500+ drive-thru, viral failures, ritorno a sistema ibrido. Il problema? Mancato testing su casi limite—accenti, rumore di fondo, ordini non standard. Hanno ottimizzato per l'happy path e dimenticato la long tail.

RAND ha identificato 5 cause root attraverso 65 interviste a esperti (studio magnifico, dovresti leggerlo):

Misunderstanding del problema (più comune): "Vogliamo AI" invece di "Vogliamo ridurre i tempi di risposta customer support da 4 ore a 30 minuti"

Mancanza di training data necessari: pensano di averli, ma hanno Excel sporchi, non dataset labellati

Focus su tecnologia invece che su soluzione: "Dobbiamo usare GPT-4" invece di "Dobbiamo risolvere X"

Infrastruttura inadeguata per data governance: i dati esistono ma sono sparsi in 15 sistemi diversi che non parlano tra loro

Problemi troppo difficili per AI: alcune cose non sono risolvibili con ML, ma nessuno vuole dirlo al board

Le barriere specifiche per PMI sono diverse: 50% delle PMI riporta che i dipendenti mancano di AI skills (OECD), 82% delle SMB più piccole cita "AI isn't applicable" come ragione di non-adozione.

SLM o LLM: una scelta operativa, non filosofica.

La verità? Non è che AI non sia applicabile. È che il gap tra "GPT-4 può fare cose magiche" e "Come lo implemento nel mio ERP del 2010" è immenso—e tutti vendono la magia, nessuno vende il ponte.

La soluzione che ho visto funzionare: inizia microscopicamente piccolo. Un caso d'uso. Un processo. Outcome realistico e misurabile. "Ridurre del 30% il tempo di classificazione lead" non "Trasformare l'azienda con AI". Focus su task ad alto volume, basso rischio. E considera fortemente partnership esterne—dato il 2x tasso di successo, è difficile giustificare sviluppo interno a meno che tu non sia già un'azienda tech.

Dove sta andando davvero il mercato

Il tema dominante al CES era "Physical AI"—l'AI che esce dagli schermi ed entra nei robot, nei veicoli, nei device edge. Non più "Agentic AI" che promette autonomia futura, ma AI che oggi salda componenti, guida veicoli, analizza sensori in tempo reale. Jensen Huang di NVIDIA l'ha dichiarato esplicitamente: "The ChatGPT moment for physical AI is here." Ma questi sistemi embedded non girano GPT-4. Girano modelli 7B-13B ottimizzati per inference su chip edge—esattamente quello di cui stiamo parlando.

Le proiezioni Gartner sono nette: entro 2027, le organizzazioni useranno SLM task-specific a volume 3x superiore rispetto a LLM general-purpose. Oltre il 50% dei modelli GenAI enterprise saranno domain-specific (dall'1% del 2024).

Questo non è wishful thinking—è già in atto. Al CES l'hardware raccontava la stessa storia:

AMD Ryzen AI 400: 60 NPU TOPS, abilita inference on-device per modelli 7B

Intel Core Ultra Series 3: 122 TOPS totali, primo processo 18A con 15% better performance per watt

NVIDIA Jetson AGX Orin: 275 TOPS per robotica e autonomous systems

L'AI sta migrando dal cloud all'edge. Non perché è più figo, ma perché è più economico e più veloce. Un modello 7B che gira su un chip ARM nel tuo device risponde in 30ms e costa zero dopo l'acquisto hardware. API GPT-4 risponde in 800ms e ti addebita ogni query.

Il mercato SLM è proiettato crescere da $0,93B (2025) a $5,45B entro 2032 con CAGR del 28,7%. Per contesto: il mercato LLM crescerà pure, ma più lentamente. Il growth delta è nei modelli specializzati.

I dati di adozione SME supportano la tesi: 55% delle small business ora usa AI (dal 39% del 2024), con 91% che riporta revenue lift e 86% che riporta improved margins. Non sono più gli early adopter tech-savvy—sono parrucchieri che usano AI per scheduling, officine meccaniche che usano AI per diagnostica preventiva.

Il gap adozione tra large firms e SMB si è chiuso: da 1.8x in febbraio 2024 a near parity ad agosto 2025. L'AI si è democratizzata non perché GPT-4 è diventato accessibile, ma perché gli SLM lo sono.

Cosa significa per te (lunedì mattina)

La strategia concreta che emerge da tutte queste conversazioni:

Fase 1 - Prototipo (settimane 1-4):

Usa GPT-4o Mini o Claude Haiku per validare il caso d'uso. Investi $100-500 in API calls. Obiettivo: confermare che il problema è risolvibile con AI e raccogliere primi 1.000+ esempi reali di input/output corretti. Non cercare perfezione—cerca segnale.

Fase 2 - Specializzazione (settimane 5-8):

Fine-tune modello open-source 7B (Llama 3.1 8B, Mistral 7B, o Phi-4) sui tuoi dati. Costo una tantum: $500-3.000 a seconda se fai in-house o outsourci. Obiettivo: performance superiore a GPT-4 sul tuo task specifico, a frazione del costo ricorrente.

Fase 3 - Hybrid routing (settimane 9+):

Deploy modello fine-tuned per 80-90% query routinarie. Mantieni fallback a GPT-4o Mini/Claude per casi limite complessi (monitora quali, spesso scopri pattern che puoi re-incorporare in fine-tuning successivo). Costo ricorrente: $500-2.000/mese vs $5.000-30.000/mese pure API—e scala molto meglio.

Prototipo. Specializzazione. Produzione.

La verità scomoda: le aziende che stanno vincendo non usano modelli frontier per competitive advantage. AT&T, IBM, Bloomberg—non stanno aspettando GPT-6. Hanno costruito moat con modelli specializzati deployati su dati proprietari.

Il competitive moat non è l'accesso a GPT-5. È domain expertise codificata in modelli fine-tuned che costano centesimi per query e che i tuoi competitor non possono replicare perché non hanno i tuoi dati, i tuoi processi, la tua conoscenza specifica.

GPT-5.2 è impressionante. Ma per il 90% delle PMI, è come comprare un supercomputer per fare Excel. Funziona? Sì. È la scelta giusta? Raramente.

📄 Whitepaper AI per PMI 2026

20-25 pagine di analisi pratica, zero hype

Cosa include:

✓ Modello decisionale completo: quando SLM vs LLM

✓ 10 casi d'uso concreti con ROI calculations

✓ Analisi completa CES 2026: hardware, chip, trend

✓ Errori da €100K+ che ho visto commettere (casi reali)

✓ Hardware combinations: best price/performance

✓ Strategie actionable da implementare subito

Disponibile nelle prossime settimane

Fabio Lauria

CEO & Founder, ELECTE

P.S. - Il Whitepaper esce tra 2-3 settimane. Prima wave limitata a 200 persone—se vuoi vedere i numeri reali che le aziende non condividono pubblicamente, rispondi a questa email ora.

Benvenuti nella Newsletter di Electe

Questa newsletter esplora l'affascinante mondo dell'intelligenza artificiale, raccontando come sta trasformando il nostro modo di vivere e lavorare. Condividiamo storie coinvolgenti e scoperte sorprendenti sull'IA: dalle applicazioni più creative ai nuovi strumenti emergenti, fino all'impatto che questi cambiamenti hanno sulla nostra vita quotidiana.

Non è necessario essere esperti di tecnologia: attraverso un linguaggio chiaro e esempi concreti, trasformiamo concetti complessi in racconti avvincenti. Che siate interessati alle ultime scoperte dell'IA, alle innovazioni più sorprendenti o semplicemente vogliate rimanere aggiornati sulle tendenze tecnologiche, questa newsletter vi guiderà alla scoperta delle meraviglie dell'intelligenza artificiale.

È come avere una guida curiosa e appassionata che ogni settimana vi porta alla scoperta degli sviluppi più interessanti e inaspettati nel mondo dell'IA, raccontati in modo coinvolgente e accessibile a tutti.

Iscriviti ora per accedere all'archivio completo della newsletter. Unitevi a una community di curiosi ed esploratori del futuro.