Adozione esplosiva, fiducia limitata.

MCP non sta incontrando resistenze nonostante il suo successo.

Le sta incontrando proprio a causa del suo successo.

Quando una tecnologia funziona davvero, smette di essere trattata come una demo.

E inizia a essere giudicata per l’unica cosa che conta: il controllo.

È quello che sta succedendo a MCP – Model Context Protocol.

In poco più di un anno è diventato il linguaggio comune con cui i modelli di intelligenza artificiale parlano con strumenti, dati e sistemi. È ovunque: nei tool per sviluppatori, nei prototipi, nei workflow di sperimentazione.

Eppure, proprio mentre l’adozione accelera, le aziende stanno facendo l’opposto di quello che ci si aspetterebbe:

non lo espongono.

Lo chiudono.

Lo mediano dietro strati sempre più rigorosi di controllo.

Contraddizione?

Solo se si guarda MCP con la lente sbagliata.

Un anno di MCP, guardando ai fatti

Nel novembre 2024 Anthropic presenta il Model Context Protocol, descrivendolo come “l’USB-C dell’AI”: uno standard aperto per collegare modelli e strumenti senza integrazioni su misura

👉 https://www.anthropic.com/news/model-context-protocol

Nel marzo 2025 OpenAI lo adotta ufficialmente.

Google segue poco dopo.

A fine 2025 gli SDK MCP superano 97 milioni di download mensili.

Poi arriva il segnale che conta davvero.

A gennaio 2026:

Microsoft disabilita MCP come impostazione predefinita negli ambienti enterprise

GitHub Copilot richiede liste di autorizzazione approvate centralmente

Salesforce mantiene MCP solo in modalità pilota, con monitoraggio continuo

Il protocollo più usato dell’AI moderna è anche quello che le aziende meno vogliono lasciare esposto in produzione.

Questo non è un segnale di allarme.

È il comportamento tipico di un’organizzazione quando una tecnologia smette di essere sperimentale e inizia a contare davvero.

Non è un incidente.

È una reazione razionale e prevedibile a una tecnologia che ha smesso di essere opzionale.

Il livello che fa davvero la differenza

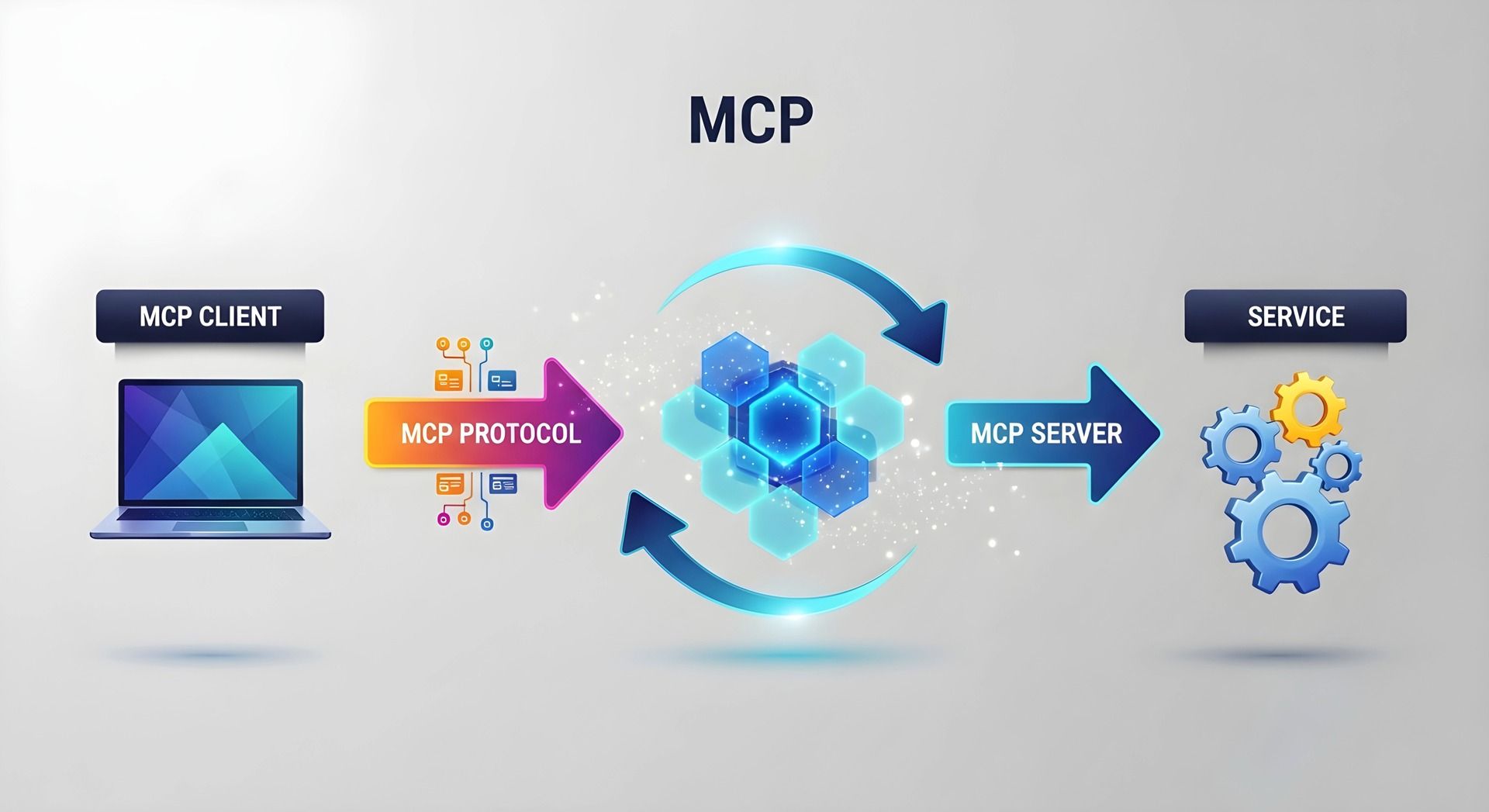

MCP (Model Context Protocol) è un protocollo che permette ai modelli di intelligenza artificiale di collegarsi a strumenti, dati e servizi esterni in modo standardizzato.

In pratica, definisce come il modello può “chiedere” al sistema di fare qualcosa — leggere un file, interrogare un database, chiamare un’API — senza integrazioni su misura.

È questo che lo rende così potente: una volta adottato, gli strumenti diventano immediatamente accessibili agli agenti AI.

Ed è anche il motivo per cui le aziende hanno iniziato a trattarlo con estrema cautela.

Cosa fanno davvero le grandi aziende con MCP

(spoiler: non quello che pensate)

I numeri di adozione sono impressionanti.

Il modo in cui MCP viene rilasciato in produzione è molto più prudente.

Bloomberg: velocità sì, esposizione no

Bloomberg ha dichiarato di aver ridotto il tempo di messa in produzione “da giorni a minuti” grazie a MCP.

Ma non esponendo MCP.

Ha costruito un layer interno di mediazione che traduce, valida e controlla ogni chiamata.

Il risultato è un sistema in cui agenti e strumenti collaborano liberamente, ma sotto controllo totale.

Amazon: MCP come adattatore, non come superficie

Amazon racconta (citato da The Pragmatic Engineer) che “la maggior parte degli strumenti interni ha aggiunto supporto MCP”

👉 https://blog.pragmaticengineer.com/amazon-internal-tools/

Il dettaglio chiave è un altro: Amazon è API-first da oltre 20 anni.

MCP non sostituisce le API.

Le traduce.

La sicurezza non è stata aggiunta dopo.

Era già parte dell’infrastruttura.

Microsoft: il segnale più onesto

GitHub Copilot Business ed Enterprise rendono MCP:

disabilitato di default

attivabile solo con regole esplicite

governato da allowlist organizzative

In una discussione ufficiale su GitHub, un commento sintetizza la posizione:

“I server MCP sono troppo pericolosi per essere rilasciati a livello organizzativo senza controlli rigorosi.”

Il pattern è sempre lo stesso:

MCP vive dentro. Non viene mai esposto direttamente.

I dati che spiegano perché

Qui il quadro diventa meno emotivo e più chiaro.

Uno studio accademico del 2025 ha analizzato 1.899 server MCP open source:

7,2% con vulnerabilità di sicurezza generiche

5,5% vulnerabili a tool poisoning specifico MCP

66% con difetti di codice

👉 https://arxiv.org/abs/2506.13538

Un secondo studio ha dimostrato che un LLM può essere indotto, via MCP, a:

eseguire codice dannoso

rubare credenziali

ottenere controllo remoto su sistemi collegati

👉 https://arxiv.org/abs/2504.03767

Scansioni indipendenti (Knostic, Backslash Security) hanno poi trovato migliaia di server MCP:

senza autenticazione

con permessi eccessivi

esposti su reti interne e pubbliche

Il dato che conta per chi decide:

solo il 28% delle Fortune 500 ha MCP in produzione

il 75% lo usa dietro gateway, audit e regole di prevenzione perdita dati

Gartner lo dice in modo diplomatico:

Entro il 2026, il 75% dei fornitori di API gateway includerà funzionalità MCP

👉 https://www.gartner.com/en/articles/api-gateway-trends

Traduzione: l’infrastruttura di controllo sta arrivando adesso.

La verità che l’industria sta capendo ora

MCP non è uno standard applicativo come HTTP o OAuth.

È uno strato infrastrutturale.

Il problema non è che MCP sia acerbo.

Il problema è che è stato giudicato come se dovesse essere esposto, quando in realtà nasce per essere mediato.

È un classico errore di categoria.

Tre modi realistici in cui MCP viene usato oggi

1. MCP come “centrale operativa” blindata

Nelle imprese MCP vive dietro:

API Gateway

firewall e filtri IP

regole automatiche sui dati sensibili

logging obbligatorio di ogni chiamata

Microsoft Copilot Studio lo rende esplicito: MCP è accessibile solo tramite connettori governati

👉 https://learn.microsoft.com/en-us/microsoft-copilot-studio/

2. MCP come “laboratorio personale”

I 97 milioni di download non sono rilasci aziendali.

Sono sviluppatori che usano MCP localmente, su Claude Desktop, Cursor, VS Code.

È sicuro proprio perché non tocca la produzione.

Questo spiega il paradosso:

velocissimo sui portatili, lentissimo nei data center.

3. MCP a “doppio binario” (il futuro prossimo)

Prototipi aperti per sperimentare.

Produzione blindata per rilasciare.

Registry privati, governance centralizzata, separazione netta degli strati.

È il modello che sta emergendo per il 2026.

Perché in ELECTE trattiamo MCP come infrastruttura, non come magia

In ELECTE lavoriamo con PMI europee che vogliono usare l’AI senza trasformarla in un rischio operativo.

Per questo MCP non è una feature da vendere.

È uno strato da governare.

Quando integriamo dati e strumenti:

MCP vive nel backend

dietro API controllate

con ambiti limitati e tracciamento completo

Il cliente vede analisi, non protocolli.

Non è prudenza eccessiva.

È la lezione che emerge osservando cosa fanno Bloomberg e Amazon, non cosa promettono le demo.

Tre mosse concrete (non “aspetta e vedi”)

1. Sperimenta subito, ma nel perimetro giusto

Usa MCP localmente per capire il potenziale, senza rischi.

2. Costruisci governance prima di integrare

Registro strumenti, logging, blocco dati sensibili.

Senza questo, MCP non va in produzione.

3. Se costruisci prodotti AI, separa sempre gli strati

MCP interno per velocità.

API esterna per controllo.

Il verdetto

MCP non è acerbo.

È una tecnologia che è arrivata prima dell’infrastruttura che la rende governabile.

La domanda giusta per il 2026 non è:

“MCP è maturo?”

Ma:

“Quale strato di MCP siamo pronti a controllare?”

Perché il futuro dell’AI enterprise non sarà

“tutto aperto via MCP”,

ma

“tutto controllato, via MCP mediato”.

Non è un’opinione.

È ciò che accade quando una tecnologia diventa abbastanza utile da non poter più essere ignorata — ed entra nei sistemi reali.

MCP non si può fermare.

Si può solo decidere come entra nei sistemi aziendali, da dove passa e chi lo governa.

Ed è su queste decisioni — non sull’adozione in sé — che si gioca la differenza tra sperimentazione e produzione.

Fabio Lauria

CEO & Founder, ELECTE S.R.L.

Fonti e approfondimenti

Repository ufficiale MCP (GitHub)

MCPSafetyScanner (tool open source)

Report Knostic su server MCP esposti

Backslash Security MCP exposure report

Xenoss – MCP enterprise adoption report

Linux Foundation – governance MCP (luglio 2025)

Benvenuti nella Newsletter di Electe

Questa newsletter esplora l'affascinante mondo dell'intelligenza artificiale, raccontando come sta trasformando il nostro modo di vivere e lavorare. Condividiamo storie coinvolgenti e scoperte sorprendenti sull'IA: dalle applicazioni più creative ai nuovi strumenti emergenti, fino all'impatto che questi cambiamenti hanno sulla nostra vita quotidiana.

Non è necessario essere esperti di tecnologia: attraverso un linguaggio chiaro e esempi concreti, trasformiamo concetti complessi in racconti avvincenti. Che siate interessati alle ultime scoperte dell'IA, alle innovazioni più sorprendenti o semplicemente vogliate rimanere aggiornati sulle tendenze tecnologiche, questa newsletter vi guiderà alla scoperta delle meraviglie dell'intelligenza artificiale.

È come avere una guida curiosa e appassionata che ogni settimana vi porta alla scoperta degli sviluppi più interessanti e inaspettati nel mondo dell'IA, raccontati in modo coinvolgente e accessibile a tutti.

Iscriviti ora per accedere all'archivio completo della newsletter. Unitevi a una community di curiosi ed esploratori del futuro.